Unternehmen schwimmen nur so in Daten. Doch ohne ein gutes Datenqualitätsmanagement treiben sie orientierungslos im eigenen Daten-Meer: Sie wissen nicht, welche Informationen relevant, welche Daten wirklich aussagekräftig sind. Sie laufen Gefahr, ihre Managemententscheidungen auf schlechte Daten zu stützen. Ein starkes Datenqualitätsmanagement (DQM) hingegen stellt sicher, dass alle Daten auch aussagekräftig sind für Unternehmensentscheidungen. Worauf es dabei ankommt, erfahren Sie in diesem Beitrag.

Definition: Datenqualität und Datenqualitätsmanagement

Datenqualität beschreibt die Korrektheit, die Relevanz und die Verlässlichkeit von Daten, abhängig vom Zweck, die die Daten in einem bestimmten Zusammenhang erfüllen sollen. Dieser Zweck kann je nach Unternehmen und Einsatzbereich variieren. Für ein Unternehmen ist die Vollständigkeit der Daten wichtig, für ein anderes die Genauigkeit. In beiden Fällen ist die Qualität der Daten nicht ausreichend, wenn sie ihren Zweck (Vollständigkeit oder Genauigkeit) nicht erfüllen.

Das Datenqualitätsmanagement (DQM) beschäftigt sich daher mit der kontinuierlichen Überwachung und Sicherung der Datenqualität. Das DQM bezeichnet dabei sämtliche Maßnahmen, die eine vermögenswerte Betrachtung, Steuerung und Qualitätssicherung von Daten in einem Unternehmen ermöglichen. Datenqualitätsmanagement ist dabei eine Teildisziplin einer ganzheitlichen Data Governance Strategie , die die Menschen, Prozesse und Technologien umfasst, die für eine gute Qualität aller Unternehmensdaten verantwortlich sind.

Datenqualitätsmanagement als kritischer Erfolgsfaktor für Organisationen

Die Vorteile einer konsistenten Datenqualität im Unternehmen sind vielfältig und erstrecken sich über mehrere Bereiche. So lassen sich mit einer guten Datenqualität regulatorische Anforderungen leichter bedienen, da Daten nicht nur schnell, sondern auch zuverlässig zur Verfügung stehen. Man denke hier an die bevorstehenden Nachhaltigkeitsberichte, die Unternehmen vorlegen müssen, sowie die Anforderungen durch die DSGVO. Neben den Vorteilen in der Regulatorik profitieren Unternehmen mit einem Datenqualitätsmanagement zudem von besseren Einblicken in die Bedürfnisse ihrer Kund:innen. Eine 360°-Kundensicht entsteht, auf Basis derer zum Beispiel Entscheidungen in der Produktentwicklung besser getroffen werden können.

Auch können Unternehmen mit einem Datenqualitätsmanagement ihre Prozesse effektiver optimieren, da sie ihre Prozessdaten besser analysieren und Schwachstellen früher identifizieren können. Das bedeutet im Umkehrschluss, dass Unternehmen mit einem gut organisierten Datenmanagement und einer hohen Datenqualität Daten effizienter und intelligenter nutzen und damit ihre Wettbewerbsfähigkeit steigern.

Wie datengetrieben sind die deutschen Unternehmen?

Dass datenbasierte Entscheidungen gute Entscheidungen sind, haben bereits 75 % der deutschen Banken und Versicherungen verinnerlicht. Sie gaben in einer Lünendonk-Studie an, den Wandel zu einer datengetriebenen Organisation bei sich im Unternehmen zu priorisieren.

Gleichzeitig wissen 72 % dieser Unternehmen, dass ein solcher Wandel nur mit einem proaktiven Datenmanagement gelingen kann¹ .

Datenqualität messen: Methoden und Tools zur Bewertung von Datenqualität

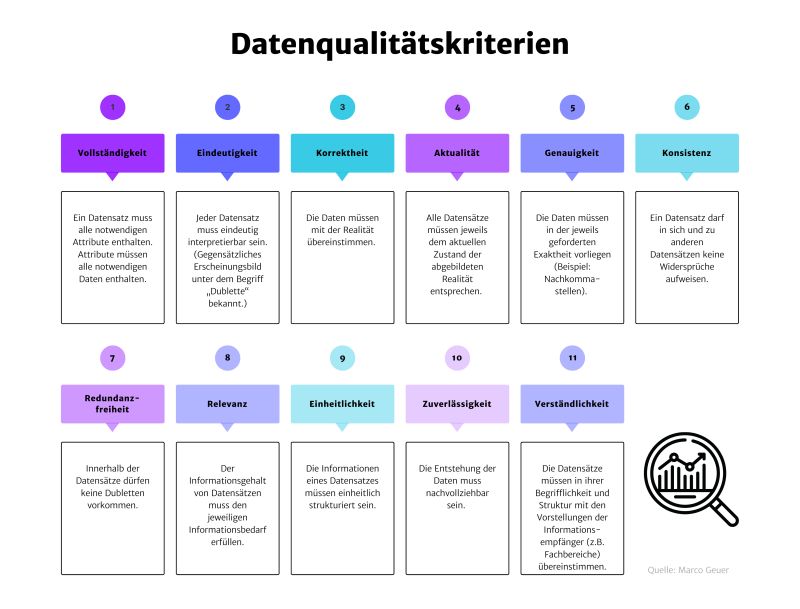

Um sinnvolle Verbesserungsmaßnahmen umsetzen zu können, müssen die Daten, auf denen die festgelegten Maßnahmen beruhen, qualitativ hochwertig sein. Doch wie lässt sich die Datenqualität messen? Hierzu bedient man sich der sogenannten Datenqualitätskriterien oder auch Dimensionen wie Vollständigkeit, Eindeutigkeit, Korrektheit etc. In der Praxis haben sich dafür insgesamt 11 Dimensionen als gut anwendbar herausgestellt.

Basierend auf diesen Kriterien werden die vorhandenen Daten im Unternehmen mit Hilfe sogenannter Data Quality Tools bewertet. Dadurch werden etwaige Regelverletzungen und daraus resultierende Datenqualitätsprobleme offengelegt. Für diesen Identifikationsprozess eignet sich beispielsweise die Friday-Afternoon-Methode . Dabei setzen sich Manager:innen, die datenbasierte Entscheidungen treffen, mit 2-3 Personen aus ihrem Team zusammen und besprechen – ursprünglich und im amerikanischen Raum meist am Freitagnachmittag – potenzielle Schwachstellen und Fehler im Datensatz. Das führt nicht nur dazu, dass offensichtliche Fehler entdeckt werden, sondern dass auch das Team für das Thema Datenqualität sensibilisiert wird.

Zentrale Herausforderungen im Datenqualitätsmanagement

Wenn sowohl Datenmenge als auch Datenvielfalt in einem Unternehmen kontinuierlich zunehmen, wird ein zentrales Datenqualitätsmanagement zum einen wichtiger, zum anderen aber eben auch komplexer. So steht man einerseits vor der Herausforderung, unterschiedliche Datenstrukturen aus unterschiedlichen Quellen mit unterschiedlichen Qualitätsniveaus in einen dem Zweck entsprechenden sinnvollen Zusammenhang zu bringen. Andererseits muss man immer größere Datenmengen in immer kürzerer Zeit mit hoher Qualität verarbeiten und für unterschiedliche Stakeholder:innen aufbereiten. All das erfordert ein zusätzliches Wissen der verantwortlichen Mitarbeiter:innen zu den Themen Datenmanagement und Data Governance sowie ein Aufbrechen sogenannter Datensilos, damit ein zentrales Datenqualitätsmanagement überhaupt erst möglich wird.

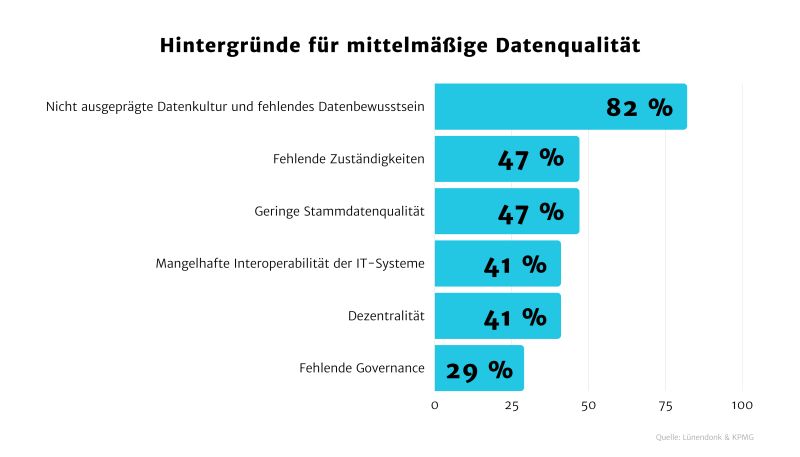

Von ähnlichen Herausforderungen berichten auch die befragten Unternehmen der Lünendonk-Studie. So stufen 55 % ihre Datenqualität als mittelmäßig ein. Als häufigste Gründe nannten die Verantwortlichen u.a. nicht ausgeprägte Datenkulturen sowie ein fehlendes Datenbewusstsein im Unternehmen (82 %), fehlende Zuständigkeiten (47 %) und eine geringe Stammdatenqualität (47 %). ²

Datenqualitätsmanagement implementieren: So gelingt’s!

Um ein Datenqualitätsmanagement im Unternehmen zu implementieren, braucht es zuoberst ein dezidiertes Projektteam. Das fokussiert sich über einen Zeitraum von 3-6 Monaten auf einen bestimmten Bereich, in dem eine Verbesserung der Datenqualität zu konkreten Optimierungen im Organisationsalltag führt. Wichtig ist es, eine:n Sponsor:in aus dem Vorstand oder der Geschäftsleitung für ein Steering Committee zu gewinnen. Als Projektmethode eignet sich ein agiles Verfahren mit 2 – 3 Wochensprints. Zeigt sich, dass man den ersten DQ-Verbesserungs-Prozess gut im Griff hat, kann man sich mit der übergeordneten Datenstrategie des Unternehmens befassen und das Modell in der Organisation weiter vorantreiben, um die nächsten Verbesserungsmaßnahmen einzuleiten. Wichtig dabei ist aber, dass alle Verbesserungsmaßnahmen in Bezug auf die Datenqualität eines Bereichs in Einklang mit der übergeordneten Datenstrategie des Unternehmens stehen.

So ist jedes Datenqualitätsmanagement auch von der Datenkultur im Unternehmen abhängig, bestimmt doch das allgemeine Daten-Bewusstsein der Belegschaft, wie sorgfältig mit Daten umgegangen wird. Organisationen können hier zwar alle notwendigen technischen Vorkehrungen treffen und entsprechende Analyse-Tools und zentrale Datenbanken einführen. Doch die Förderung einer Datenkultur im Unternehmen sowie die entsprechende Befähigung der Mitarbeiter:innen zählen genauso zu wichtigen Voraussetzungen für ein gelingendes Datenqualitätsmanagement.

Wo ist Datenqualitätsmanagement organisatorisch am besten angesiedelt?

Erfahrungsgemäß starten die meisten Organisationen mit einem Data Quality Management im Bereich Business Intelligence / Data Warehousing. Da hier viele Daten bereits zusammengeführt werden, ist das Bewusstsein für Datenqualitätsschwächen und deren Auswirkung auf die Aussagekraft der Kennzahlen bereits stark ausgeprägt. Für den Anfang ist das akzeptabel, langfristig ist es jedoch zu kurz gegriffen. Der Wettbewerbsvorteil eines datengetriebenen Unternehmens liegt in der Umsetzung einer ganzheitlichen, organisationsübergreifenden Datenstrategie. Darunter fällt ein zentrales Datenqualitätsmanagement, das über alle Organisationsbereiche hinweg Daten- und Verantwortlichkeitssilos aufbricht und interdisziplinär zusammenführt, beispielsweise in sogenannten Competence Centers.

Fazit: Ein Bewusstsein für Datenqualität lässt sich erlernen

Mit einem guten Datenqualitätsmanagement sichern Unternehmen also nicht nur die Qualität ihrer Daten, sondern auch automatisch die Qualität ihrer datenbasierten Entscheidungen. Das trägt zum übergeordneten Unternehmenserfolg bei. Grundvoraussetzungen dafür sind sowohl eine technische Interoperabilität der IT-Landschaft als auch eine organisationsweite Datenkultur, die ein Bewusstsein für hohe Datenqualität bei den Mitarbeiter:innen fördert. Das gelingt mit entsprechenden Weiterbildungen. Denn die Kompetenz für Data Management schlummert nicht nur in Data Manager:innen, sondern in jeder:jedem Mitarbeiter:in.

¹Lünendonk & KPMG, 2022, „Von Datensilos zu Datenströmen: Der Wandel von Banken und Versicherungen zu datengetriebenen Unternehmen“. https://www.luenendonk.de/produkte/studien-publikationen/luenendonk-studie-2022-von-datensilos-zu-datenstroemen-der-wandel-von-banken-und-versicherungen-zu-datengetriebenen-unternehmen-it/.

²Lünendonk & KPMG, 2022, „Von Datensilos zu Datenströmen: Der Wandel von Banken und Versicherungen zu datengetriebenen Unternehmen“. https://www.luenendonk.de/produkte/studien-publikationen/luenendonk-studie-2022-von-datensilos-zu-datenstroemen-der-wandel-von-banken-und-versicherungen-zu-datengetriebenen-unternehmen-it/.