Machine Learning: Von Daten zu echten Wettbewerbsvorteilen

Inhalte

Machine Learning verstehen und wirksam einsetzen

Was früher Bauchgefühl war, ist heute Berechnung: Machine Learning ermöglicht Unternehmen, schneller, sicherer und smarter zu entscheiden. Als Teilbereich der künstlichen Intelligenz ermöglicht Machine Learning deinem Unternehmen, aus vorhandenen Daten Muster zu erkennen und präzise Vorhersagen zu treffen, ohne dass du jede einzelne Regel explizit programmieren musst.

Im Folgenden erfährst du, was maschinelles Lernen praktisch ausmacht, welche Anwendungsfelder besonders relevant sind und worauf es bei der Umsetzung in Unternehmen ankommt.

Was ist Machine Learning und wie funktioniert es im Detail?

[DEFINITION][Machine Learning][Machine Learning, auf Deutsch maschinelles Lernen, ist ein Teilbereich der künstlichen Intelligenz. Im Kern geht es darum, dass Algorithmen aus vorhandenen Daten Muster ableiten und Vorhersagen treffen können, ohne dass jede Regel von Menschen vorgegeben werden muss.]

Damit ein solches System funktioniert, durchläuft es typischerweise mehrere Schritte: Daten werden gesammelt und aufbereitet, anschließend trainiert man ein Modell, überprüft es anhand von Testdaten (Validierung) und setzt es schließlich im Einsatzumfeld ein (Deployment).

Oft wird in diesem Zusammenhang auch von Data Mining gesprochen, der gezielten Analyse großer Datenbestände, um Muster, Korrelationen und Anomalien sichtbar zu machen, die anschließend in Machine-Learning-Modelle einfließen.

Je nach Zielsetzung gibt es unterschiedliche Lernverfahren:

- Überwachtes Lernen (Supervised Learning) nutzt bekannte Eingaben und Zielwerte, um Modelle zu trainieren. Typische Methoden sind Entscheidungsbäume oder Random Forests, die Prognosen anhand logischer Fragenfolgen treffen. Sie sind für viele Business-Anwendungen bewährte Werkzeuge.

- Unüberwachtes Lernen (Unsupervised Learning) sucht eigenständig Strukturen in Daten, etwa um Kundensegmente zu identifizieren oder Auffälligkeiten zu finden.

- Neuronale Netze und Deep Learning ahmen vereinfacht die Funktionsweise des Gehirns nach und eignen sich vor allem für unstrukturierte Daten wie Text, Sprache, Bilder, Videos oder Audio.

Das Prinzip dahinter ist immer ähnlich: Das Modell vergleicht seine Vorhersagen mit den tatsächlichen Ergebnissen, berechnet den Fehler und passt seine internen Parameter an. Dieser Optimierungsprozess wiederholt sich tausendfach, bis die Vorhersagen zuverlässig genug sind.

Nach dem Training kann ein Modell auf neue, unbekannte Daten angewendet werden, etwa wenn ein Spamfilter verdächtige E-Mails erkennt, ein Empfehlungssystem passende Produkte vorschlägt oder ein Predictive-Maintenance-Modell Maschinenprobleme frühzeitig meldet. Entscheidend ist dabei die Fähigkeit zur Generalisierung: Ein gutes Modell erkennt nicht nur die gelernten Trainingsmuster wieder, sondern kann auch in völlig neuen Situationen sinnvolle Entscheidungen treffen.

Was Machine Learning anders macht als klassische IT-Systeme

[DEFINITION][Machine Learning vs. klassische IT-Systeme][Der fundamentale Unterschied zwischen Machine Learning und klassischen IT-Systemen liegt in der Herangehensweise an die Problemlösung. Klassische IT-Systeme arbeiten regelbasiert. Du musst jedem Programm explizit sagen: „wenn A passiert, dann mache B“. Diese statische Programmierung stößt schnell an Grenzen, wenn unvorhersehbare Situationen auftreten.]

Machine Learning Algorithmen hingegen werden nicht explizit für jede Situation programmiert. Stattdessen lernen sie selbständig aus Daten, erkennen Muster und können basierend auf diesen Erkenntnissen Vorhersagen treffen. Ein neuronales Netz beispielsweise analysiert Millionen von Datenpunkten, identifiziert Zusammenhänge und entwickelt die Fähigkeit, auch bei neuen, unbekannten Eingaben sinnvolle Entscheidungen zu treffen.

Diese Adaptivität macht den entscheidenden Unterschied: während ein traditionelles System bei unvorhergesehenen Situationen versagt oder aufwendige Umprogrammierung benötigt, lernt ein Machine Learning Modell kontinuierlich dazu. Es verbessert seine Leistung mit jedem neuen Datensatz und passt sich verändernden Bedingungen automatisch an. Dadurch entstehen intelligente Systeme, die komplexe Aufgaben bewältigen können, ohne dass Entwickler:innen jeden einzelnen Fall antizipieren müssen.

Typische Anwendungsfelder in Unternehmen

Machine Learning durchdringt heute nahezu alle Geschäftsbereiche und löst konkrete Probleme, die Unternehmen täglich beschäftigen. Die vielfältigen Einsatzmöglichkeiten zeigen, warum maschinelles Lernen zur Standardtechnologie wird.

Automatisierung repetitiver Prozesse

Repetitive Aufgabenkosten Zeit, Geld und demotivieren Mitarbeiter:innen. Machine Learning unterstützt hier als Enabler: Anstatt starre Regeln für jede Eventualität zu programmieren, entstehen Regeln datengetrieben und können sich durch erneutes Training anpassen. In Kombination mit Automatisierungstechniken wie Optical Character Recognition (OCR) für die Texterkennung oder Natural Language Processing (NLP) für die Sprachverarbeitung lassen sich Dokumentenprozesse vom Erfassen bis zur Weiterleitung in deine IT-Systeme deutlich effizienter gestalten.

Intelligent Document Processing Systeme kombinieren OCR mit Machine Learning Modellen und lesen Inhalte aus Papierdokumenten digital aus. Rechnungen, Verträge und Formulare werden automatisch erfasst, klassifiziert und an die richtigen Abteilungen weitergeleitet. Manuelle Dateneingaben gehören der Vergangenheit an, Fehlerquellen verschwinden.

Chatbots im Kundensupport demonstrieren den praktischen Nutzen eindrucksvoll. Ein großer Anteil an Kundenanfragen sind Standardfragen: „Wo ist meine Sendung?“, „Wann erhalte ich die Rechnung?", „Wie funktioniert die Rückgabe?". Auf Machine Learning basierende Chatbots verstehen diese Anliegen mittels Natural Language Processing und liefern rund um die Uhr passende Antworten. Komplexere Fälle werden an menschliche Mitarbeiter:innen weitergeleitet, die sich dann auf wertschöpfende Aufgaben konzentrieren können.

Die Kombination mit Robotic Process Automation (RPA), der softwaregesteuerten Automatisierung von Geschäftsprozessen, verstärkt diesen Effekt. Machine Learning Modelle erledigen repetitive Aufgaben schneller und fehlerfreier als es durch manuelle Bearbeitung möglich wäre. Deine Mitarbeiter:innen gewinnen Zeit für kreative und strategische Tätigkeiten, während die Maschine die Routine übernimmt.

Prognosen und datengetriebene Entscheidungen

Vorhersagemodelle gehören zu den wertvollsten Machine Learning Anwendungen. Immer wenn du zukünftige Entwicklungen auf Basis historischer Daten abschätzen willst, unterstützt Machine Learning deine Entscheidungsfindung:

- Regressionsmodelle, statistische Verfahren zur Vorhersage kontinuierlicher Werte und neuronale Netze lernen aus vergangenen Verkaufszahlen und Einflussfaktoren wie Saison, Trends oder Preisen, um künftige Verkaufszahlen präzise vorherzusagen. Diese Absatz- und Nachfrageprognosen optimieren Lagerbestände und vermeiden Engpässe oder Überproduktionen. In der Finanzplanung prognostizierst du Umsätze, Kosten oder Cashflows unter verschiedenen Szenarien.

- Klassifikationsmodelle ordnen Daten in Klassen ein. Ein Beispiel sind Kreditrisikomodelle: Sie sagen vorher, ob ein Kunde zur Klasse „kreditwürdig“ oder „nicht kreditwürdig“ gehört, basierend auf Merkmalen ähnlicher Personen in den Trainingsdaten. So bestimmen Kreditinstitute Ausfallwahrscheinlichkeiten präziser und treffen objektivere Entscheidungen.

- Predictive Maintenance revolutioniert Industrie und Logistik: Machine Learning Modelle analysieren kontinuierlich Sensordaten von Maschinen, um Wartungsbedarfe frühzeitig zu erkennen, bevor Ausfälle eintreten.

- Churn Prediction, die Vorhersage von Kundenabwanderung, identifiziert gefährdete Kund:innen, bevor sie abwandern. ML-Modelle analysieren Nutzerverhalten und erkennen Warnsignale wie nachlassende Nutzung oder negative Rückmeldungen. Dein Vertriebsteam kann gezielt gegensteuern und wertvolle Kund:innen halten.

Muster- und Anomalieerkennung

Machine Learning glänzt bei der Erkennung verborgener Muster in großen Datenmengen. Täglich entstehen in Unternehmen Datenfluten, ob im Finanzsektor, IT-Betrieb oder in der Produktion. Darin verbergen sich Chancen und Risiken, die menschliche Analyst:innen niemals vollständig erfassen könnten.

Betrugserkennung demonstriert diese Stärke eindrucksvoll. Banken und Online-Händler setzen ML ein, um verdächtige Transaktionsmuster in Echtzeit aufzuspüren. Klassische, regelbasierte Fraud-Filter stoßen an Grenzen, weil Betrüger:innen ihre Taktiken ständig ändern. Machine Learning Algorithmen lernen kontinuierlich dazu und erkennen betrügerische Aktivitäten selbst bei völlig neuen Betrugsmustern.

Auffällige Nutzungsverhalten, geografische Unregelmäßigkeiten oder abweichende Navigationsmuster deuten auf Betrugsversuche hin. Das System schlägt rechtzeitig Alarm und schützt vor finanziellen Schäden. Computer Vision Modelle revolutionieren die Qualitätssicherung: sie analysieren Bilder von Fertigungsstraßen und sortieren fehlerhafte Teile anhand kleinster Abweichungen automatisch aus. Das geschieht schneller und zuverlässiger als eine manuelle Sichtprüfung. Computer Vision bezeichnet die Fähigkeit von Computern, Bilder und Videos zu verstehen und zu interpretieren.

In der IT überwachen Machine Learning Modelle Log-Dateien und Netzwerktraffic, um Sicherheitsvorfälle oder Systemfehler zu erkennen. Ein Frühwarnsystem meldet ungewöhnlich hohe Lasten, verdächtige Zugriffe oder Abweichungen vom normalen Betrieb sofort. So entsteht proaktive Problembehandlung von Produktionsfehlern bis zu Cyberangriffen.

Personalisierung und Kundeninteraktion

Personalisierung wird zum Wettbewerbsvorteil und Machine Learning macht sie skalierbar:

- Empfehlungssysteme analysieren das Verhalten jedes einzelnen Nutzers und unterbreiten individuelle Produkt- oder Inhaltsvorschläge. Amazon generiert einen signifikanten Anteil seines Umsatzes durch Machine Learning-basierte Produktempfehlungen. Diese Systeme arbeiten mit kollaborativem Filtern – einem Verfahren, das Ähnlichkeiten zwischen Nutzer:innen oder Produkten berechnet –oder künstlichen neuronalen Netzen und werten Millionen von Interaktionen aus. Sie finden relevante Zusammenhänge zwischen Produkten und Nutzer:innen, die menschliche Analyst:innen niemals entdecken würden. Die Personalisierung steigert Kundenzufriedenheit und Umsatz gleichermaßen.

- Clustering-Algorithmen, unüberwachte Lernverfahren zur Gruppierung ähnlicher Datenpunkte, ermöglichen präzise Kundensegmentierung: Kund:innen mit ähnlichem Verhalten werden gruppiert für zielgenaue Marketingkampagnen. Sentimentanalyse-Modelle durchsuchen Bewertungen, E-Mails oder Social Media Posts nach Stimmungen und Meinungen. Du erfährst automatisiert, wie deine Produkte wahrgenommen werden. Positive wie negative Trends erkennst du somit frühzeitig.

- Moderne Chatbots gehen über einfache Automatisierung hinaus. Sie lernen aus jeder Konversation, berücksichtigen Kontext und lösen häufige Probleme sofort. Komplexere Anfragen leiten sie mit Voranalyse an menschliche Mitarbeiter:innen weiter. Das erhöht die Servicegeschwindigkeit und sorgt für konsistente Qualität rund um die Uhr.

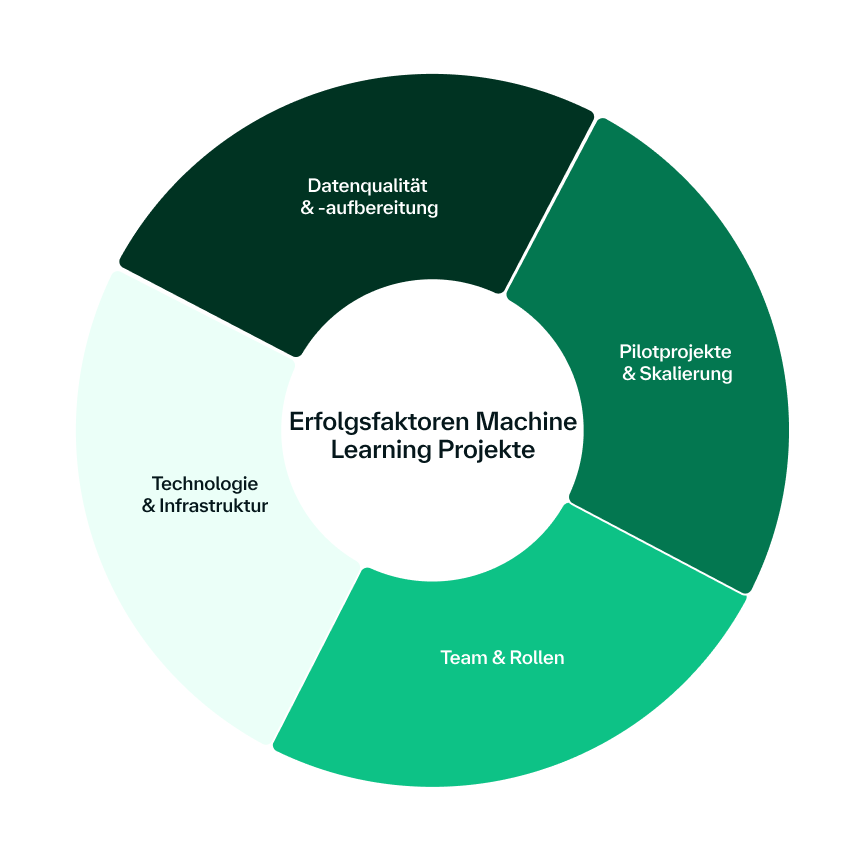

Erfolgsfaktoren für Machine Learning Projekte

Der Erfolg von Machine Learning Projekten hängt von mehreren kritischen Faktoren ab. Unternehmen, die diese Aspekte systematisch angehen, erzielen deutlich bessere Ergebnisse als jene, die Machine Learning als rein technische Herausforderung betrachten.

Datenqualität und Datenaufbereitung

Hochwertige Datenbilden das Fundament erfolgreicher Machine Learning Projekte. „Garbage in, garbage out" – diese Grundregel des maschinellen Lernens verdeutlicht die zentrale Bedeutung der Datenqualität. Ohne saubere, strukturierte und relevante Daten können selbst die ausgefeiltesten Algorithmen keine brauchbaren Ergebnisse liefern.

In der Praxis bedeutet das: der signifikant größte Teil des Aufwandes in Machine Learning Projekten fließt in die Datenvorbereitung. Du musst Datenquellen identifizieren, Datensilos zusammenführen, Fehler und Duplikate bereinigen und fehlende Werte ergänzen. Besonders bei Predictive Maintenance Projekten benötigst du Sensoren, die granular und genau genug messen, sowie eine ausreichende Datenhistorie.

Die Datenaufbereitung umfasst Säuberung, Deduplizierung, Harmonisierung und Normalisierung. Glücklicherweise existieren viele Frameworks und Werkzeuge für diese Aufgaben. Der Aufwand ist erheblich, aber ohne qualitative Datenbasis scheitern Machine Learning Projekte bereits im Ansatz. Kontinuierliche Datenpflege sichert die Aktualität und Konsistenz. Machine Learning Modelle sind nur so gut wie die Daten, mit denen sie trainiert werden.

Pilotprojekte und Skalierung

Eine erfolgreiche Einführung von Machine Learning beginnt klein und denkt groß. Pilotprojekte demonstrieren den Nutzen in einem überschaubaren Rahmen und sammeln wertvolle Erfahrungen. Ein Pilotprojekt muss das Problem, für das es entwickelt wurde, bereits in der Testphase lösen, messbar und nachvollziehbar.

Nur wenn der Pilot echten Mehrwert generiert, lohnt sich die Skalierung. Die Erkenntnisse aus Pilotprojekten fließen in größere Implementierungen ein: welche Datenquellen sind verfügbar? Wo liegen die technischen Hürden? Wie reagieren Nutzer:innen auf das neue System? Piloten schaffen internes Buy-in bei Stakeholder:innen und reduzieren das Risiko großer Investitionen.

Bei der Skalierung gilt es, unrealistische Erwartungen zu managen. Machine Learning ist kein Wundermittel, das sofort perfekte Ergebnisse liefert. Es ist ein lernender Prozess, der Zeit, Anpassungen und kontinuierliche Verbesserung erfordert. Iteratives Vorgehen mit regelmäßigen Evaluierungen führt zu nachhaltigen Erfolgen.

Team und Rollen

Machine Learning ist wie ein Teamsport zu betrachten. Erfolgreiche Projekte bringen Fachwissen aus verschiedenen Bereichen zusammen:

- Datenarchitekt:innen entwickeln die übergeordnete Struktur: Welche Datenquellen gibt es? Wie werden sie aufbereitet? Wo werden Zwischenergebnisse gespeichert?

- Data Engineers bauen die Datenpipelines und ETL-Prozesse, die Daten von A nach B schieben, in der richtigen Form und Qualität.

- Data Scientists experimentieren mit Algorithmen, wählen geeignete Ansätze aus und bauen Prototypen.

- Machine Learning Engineers übernehmen die produktive Implementierung: sie skalieren, deployen und monitoren die Modelle im Regelbetrieb. Sie sorgen dafür, dass Modelle kontinuierlich neue Daten erhalten und sich verbessern.

Der Mangel an Machine Learning Fachkräften macht Weiterbildung bestehender Mitarbeiter:innen essentiell. Externes Know-how kann temporär helfen, aber langfristiger Erfolg erfordert interne Kompetenzen. Wichtig ist, dass alle Beteiligten ein gemeinsames Verständnis der Ziele haben und eng zusammenarbeiten.

Technologie und Infrastruktur

Die Wahl der Machine Learning Plattform muss zu deinen Anforderungen passen. Für erste Schritte eignen sich Cloud-Services mit fertigen Machine Learning Bausteinen, die sich flexibel skalieren lassen.

Die Infrastruktur muss Training großer Modelle und Verarbeitung großer Datenmengen zuverlässig bewältigen. GPUs und verteilte Systeme werden bei komplexen Algorithmen unverzichtbar. MLOps gewinnt an Bedeutung. Es umfasst Methoden und Werkzeuge für kontinuierliche Entwicklung, Tests, Deployment und Überwachung von Machine Learning Modellen.

Automatisierte Pipelines für Datenvorbereitung, Modelltraining und Deployment erhöhen die Effizienz und Reproduzierbarkeit. ML-Modelle müssen wie Software behandelt werden: versioniert, getestet und dokumentiert. Monitoring im Produktivbetrieb zeigt, ob Modelle ihre Leistung halten oder Nachtraining benötigen.

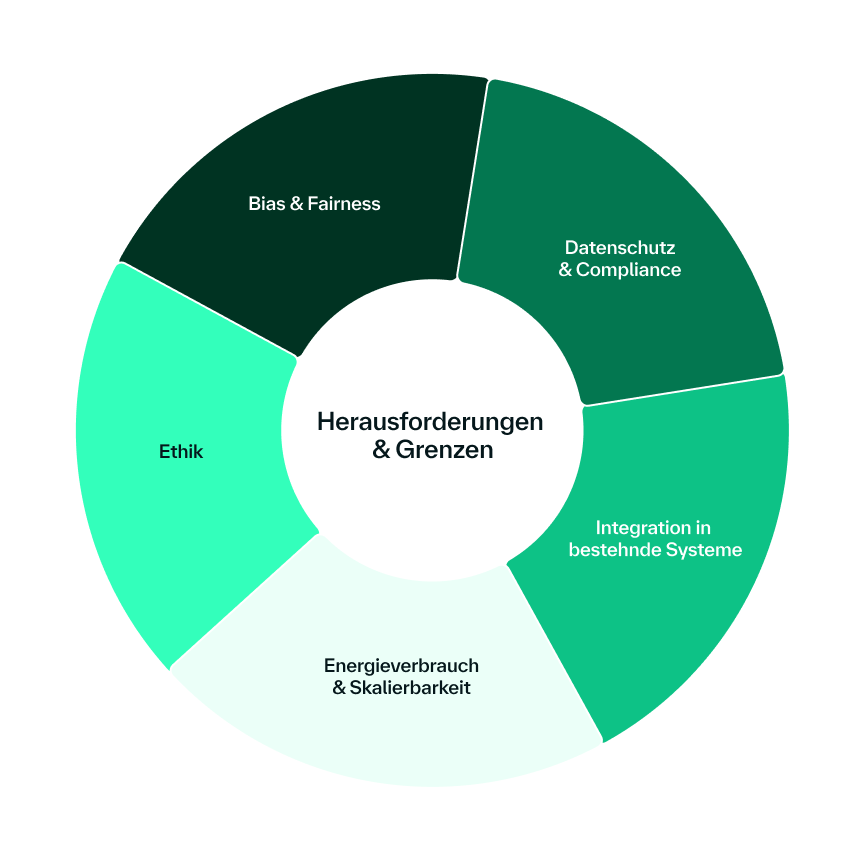

Herausforderungen und Grenzen von Machine Learning

Machine Learning bringt neben enormen Möglichkeiten auch spezifische Herausforderungen mit sich. Unternehmen müssen diese Aspekte von Beginn an mitdenken, um verantwortungsvolle und nachhaltige Machine Learning Lösungen zu entwickeln.

Bias und Fairness

Algorithmic Bias gehört zu den größten Risiken beim Einsatz von Machine Learning. Modelle lernen aus historischen Daten und diese spiegeln oft gesellschaftliche Ungleichheiten oder diskriminierende Praktiken wider. Ein klassisches Beispiel: trainierst du ein Gehaltsmodell mit Daten, in denen Frauen systematisch weniger verdienen, wird das Modell diese Verzerrung reproduzieren und beispielsweise für neue Mitarbeiterinnen niedrigere Gehälter vorschlagen.

Ähnliche Probleme entstehen bei Face-ID-Systemen zur Gesichtserkennung, die hauptsächlich mit Bildern von Menschen mit heller Hautfarbe trainiert wurden. Sie funktionieren bei anderen Ethnien deutlich schlechter. Kreditscoring-Modelle können ebenfalls bedenklich sein, wenn sie bestimmte Bevölkerungsgruppen benachteiligen. Diese Verzerrungen sind oft nicht böswillig beabsichtigt, sondern entstehen durch unvollständige oder einseitige Trainingsdaten.

Selbst große Technologiekonzerne kämpfen mit diesem Problem. Öffentliche Daten aus sozialen Medien enthalten natürliche Verzerrungen, die sich in Machine Learning Modellen manifestieren. Die Lösung erfordert bewusste Anstrengungen: diverse Trainingsdaten sammeln, Modelle auf Fairness testen und kontinuierlich auf diskriminierende Effekte überwachen. Ein Bias lässt sich nicht vollständig eliminieren, aber durch Transparenz und systematische Maßnahmen erheblich reduzieren.

Datenschutz und Compliance

In Europa ist Datenschutz kein optionales Feature, sondern rechtliche Verpflichtung. Die DSGVO setzt strenge Regeln für Datenverarbeitung und -speicherung. Machine Learning Projekte müssen von Anfang an diese Anforderungen berücksichtigen. Privacy by Design wird zum Pflichtprogramm.

Sensible Daten können lokal oder On-Premises verarbeitet werden, bevor sie anonymisiert oder maskiert an Cloud-Services weitergeleitet werden. Pseudonymisierung und Differential Privacy bieten technische Ansätze, um nützliche Erkenntnisse zu gewinnen, ohne Persönlichkeitsrechte zu verletzen. Transparenz gegenüber Betroffenen ist essentiell: Menschen müssen verstehen, welche Daten wie verwendet werden.

Zusätzlich entstehen branchenspezifische Compliance-Anforderungen. Im Finanzsektor gelten besonders strenge Regeln für algorithmische Entscheidungen. Im Gesundheitswesen sind Medizinprodukte-Verordnungen zu beachten. Die rechtzeitige Einbindung von Datenschutz- und Compliance-Expert:innen verhindert teure Nachbesserungen oderrechtliche Probleme.

Integration in bestehende Systeme

Machine Learning Lösungen müssen nahtlos in gewachsene IT-Landschaften integriert werden. Legacy-Systeme, verschiedene Datenformate und unterschiedliche Technologiestandards erschweren oft die Implementierung. APIs, Microservices und Containerisierung helfen beider Integration, erfordern aber sorgfältige Planung.

Besonders kritisch ist die Anbindung an Geschäftsprozesse. Machine Learning Modelle müssen ihre Vorhersagen zur richtigen Zeit am richtigen Ort zur Verfügung stellen: Real-time Scoring für Betrugserkennung, Batch-Verarbeitung für Inventurprognosen oder Streaming-Analytics für Anomalieerkennung. Jeder Use Case hat spezifische Anforderungen an Latenz und Durchsatz.

Das Change Management wird oft unterschätzt. Mitarbeiter:innen müssen neue Systeme verstehen und vertrauen lernen. Training und Kommunikation sind genauso wichtig wie die technische Implementierung. Ohne Nutzerakzeptanz scheitern auch technisch perfekte Lösungen.

Energieverbrauch und Skalierbarkeit

Das Training komplexer Machine Learning Modelle verbraucht erhebliche Mengen Energie. Große Sprachmodelle oder Computer Vision Systeme benötigen Wochen auf Hochleistungsrechnern. Der CO2-Fußabdruck wird zum relevanten Faktor, besonders für Unternehmen mit Nachhaltigkeitszielen.

Skalierbarkeit betrifft mehrere Dimensionen: können Modelle mit wachsenden Datenmengen umgehen? Lassen sich Trainingszeiten bei Bedarf reduzieren? Wie verhält sich die Performance bei steigender Nutzerlast? Edge Computing und Modelloptimierung bieten Ansätze, aber erfordern zusätzliche Expertise.

Cloud-Anbieterinvestieren in nachhaltige Rechenzentren und bieten optimierte Hardware für Machine Learning Workloads. Dennoch müssen Unternehmen bewusst entscheiden, welche Modellkomplexität wirklich nötig ist. Oft erzielen einfachere Algorithmen ausreichende Ergebnisse bei deutlich geringerem Ressourcenverbrauch.

Ethische und gesellschaftliche Fragen

Machine Learning beeinflusst zunehmend gesellschaftliche Strukturen und individuelle Lebensentscheidungen. Unternehmen tragen Verantwortung für die Auswirkungen ihrer Algorithmen. Ethische KI ist nicht nur eine moralische Verpflichtung, sondern auch ein Geschäftsrisiko.

Automatisierte Entscheidungssysteme beeinflussen Kredit- und Jobvergabe, Strafverfolgung oder medizinische Diagnosen. Transparenz wird zur Grundvoraussetzung: Betroffene müssen verstehen können, warum ein Algorithmus bestimmte Entscheidungen trifft. Explainable AI (XAI) entwickelt Methoden, um ML-Modelle interpretierbar zu machen.

Die Auswirkungen auf Arbeitsmärkte sind ambivalent. Während Machine Learning Routine-Aufgaben automatisiert und bestimmte Jobs überflüssig macht, entstehen neue Tätigkeitsfelder. Umschulung und Weiterbildung werden essentiell, um Menschen den Übergang zu ermöglichen. Unternehmen können durch verantwortungsvolle Automatisierung Arbeitsplätze aufwerten statt zu eliminieren.

Algorithmische Rechenschaftspflicht (Algorithmic Accountability) fordert nachvollziehbare Entscheidungsprozesse. Unternehmen müssen erklären können, wie ihre Systeme funktionieren und welche Daten sie verwenden. Regulierungsbehörden entwickeln Frameworks für KI-Governance. Proaktive Compliance wird zum Wettbewerbsvorteil.

Gesellschaftliche Akzeptanz entscheidet über den langfristigen Erfolg von Machine Learning Anwendungen. Vertrauen entsteht durch Transparenz, Fairness und nachweisbaren Nutzen. Unternehmen, die ethische Standards ernst nehmen, bauen nachhaltige Wettbewerbsvorteile auf.

Wohin entwickelt sich Machine Learning in den nächsten Jahren

Machine Learning steht am Beginn einer neuen Entwicklungsphase. Mehrere Trends werden die nächsten Jahre prägen und neue Möglichkeiten für Unternehmen schaffen.

- Foundation Models und Large Language Models demokratisieren die KI. Statt spezialisierte Modelle für jeden Anwendungsfall zu entwickeln, können Unternehmen universelle Basismodelle an ihre Bedürfnisse anpassen. Fine-Tuning wird einfacher und kostengünstiger als Training von Grund auf. Kleine Unternehmen erhalten Zugang zu hochentwickelter KI-Technologie.

- Automated Machine Learning (AutoML) reduziert den Bedarf an Spezialwissen. Plattformen automatisieren Modellauswahl, Hyperparameter-Optimierung und Feature Engineering. Citizen Data Scientists, also Fachanwender:innen ohne tiefgehende ML-Expertise, können so komplexe Analysen durchführen. Das beschleunigt die Verbreitung von Machine Learning in Unternehmen.

- Edge AI verlagert Intelligenz an den Ort des Geschehens. Smartphones, IoT-Sensoren und Industrieanlagen führen ML-Inferenz lokal durch. Das reduziert die Latenz, verbessert den Datenschutz und ermöglicht KI auch ohne Internetverbindung. Autonome Fahrzeuge oder Predictive Maintenance profitieren besonders von dieser Entwicklung.

- Federated Learning ermöglicht kollaboratives Modelltraining ohne Datenpreisgabe. Unternehmen können gemeinsam bessere Modelle entwickeln, ohne sensible Informationen zu teilen. Das ist besonders relevant für Branchen mit strikten Datenschutzanforderungen wie Gesundheitswesen oder Finanzdienstleistungen.

- Multimodale KI kombiniert Text, Bilder, Audio und Sensordaten in einem Modell. Das ermöglicht umfassenderes Verständnis komplexer Situationen. Ein Kundensupport-Bot kann gleichzeitig Text, Bilder defekter Produkte und Sprachaufzeichnungen analysieren.

- Quantum Machine Learning verspricht exponentiell schnellere Berechnungen für bestimmte Problemklassen. Während praktische Anwendungen noch Jahre entfernt sind, könnten Quantencomputer Optimierungsprobleme revolutionieren.

- Regulation und Standards werden sich etablieren. In der EU handelt es sich um den AI Act, andere Länder entwickeln eigene Frameworks. Unternehmen müssen Compliance-Anforderungen frühzeitig berücksichtigen. Gleichzeitig entstehen Industriestandards für ML-Entwicklung und -Deployment.

Machine Learning wird zur unsichtbaren Standardtechnologie. Wie das Internet wird es nahtlos in Geschäftsprozesse eingebettet sein. Entscheidend ist nicht mehr das „Ob“, sondern das „Wie gut“.

Wenn du verstehen willst, wie sich diese Technologien anwenden lassen, und deine eigenen Projekte voranbringen möchtest, findest du in unserer Kursübersicht zu Machine Learning praxisnahe Trainings, die dich genau dabei unterstützen.